知乎首次写文章,恳请大家多多担待

本人是一名大四生物信息的学生,在大数据课上,老师需要我们配置Hadoop去处理一些东西。网上的一些教程互相冲突,记录一下这个从头可以完全运行成功的教程

- 购买服务器

因为本人使用的仍然是14年的MBP,怕随随便便装个新系统把电脑给折腾坏了,这里购买的是云服务器,这里首推阿里云。

若您是常年使用谷歌搜索,请注意关闭梯子,因为阿里云是有国内国外两个系统,各自独立,虽然墙外的服务器可以免费试用2个月,但各种实名认证是绕不开的。

若您是学生,阿里云有一个开发者成长计划,专门针对在校大学生,也就是教育优惠。非常便宜,只需要9.5一个月

\2. 服务器选择和配置

这里选择的是轻量服务器,系统镜像和应用镜像不需要改变,保持默认值就行(WordPress, CentOS 7.3)

这里需要设置root权限和密码

设置成功后通过本地terminal(MAC)或者cmd(Windows)来构建ssh

1 | ssh root@**** |

然后输入之前设置的root的权限的密码(注意:这里的密码是不会有任何显示的)

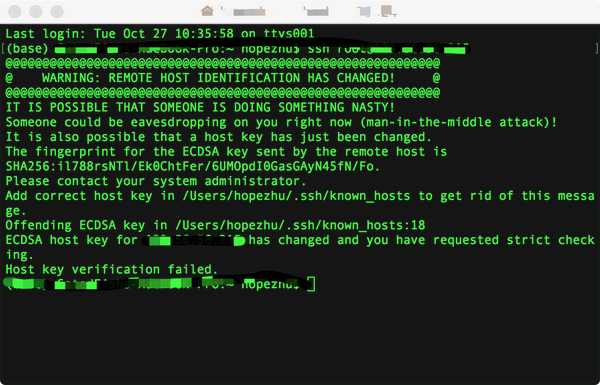

若出现上图的情况,需要清理一下之前的key

1 | ssh-keygen -R XX.XX.XX.XX |

然后再次用ssh连接,然后yes

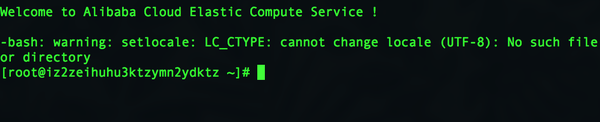

好,到此我们进入到了阿里云的服务器

\3. 我们开始配置java环境

首先下载java的jdk

1 | wget https://download.java.net/openjdk/jdk8u41/ri/openjdk-8u41-b04-linux-x64-14_jan_2020.tar.gz |

然后解压

1 | tar -zxvf openjdk-8u41-b04-linux-x64-14_jan_2020.tar.gz |

移动位置并且配置java路径

1 | mv java-se-8u41-ri/ /usr/java8 |

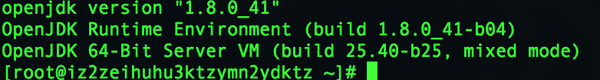

检查是否安装成功

1 | java -version |

这是理想情况,若安装成功会出现如下结果

\4. 我们进行Hadoop的安装

1 | wget https://mirrors.tuna.tsinghua.edu.cn/apache/hadoop/common/hadoop-2.9.2/hadoop-2.9.2.tar.gz |

这儿是清华的镜像源,国内的小伙伴下载比较快

按照惯例解压

1 | tar -zxvf hadoop-2.9.2.tar.gz -C /opt/ |

配置地址

1 | echo 'export HADOOP_HOME=/opt/hadoop/' >> /etc/profile |

配置yarn和hadoop

1 | echo "export JAVA_HOME=/usr/java8" >> /opt/hadoop/etc/hadoop/yarn-env.sh |

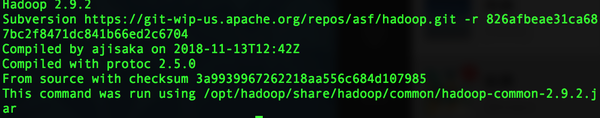

查看Hadoop 安装情况

1 | hadoop version |

若出现上图情况,则说明安装成功

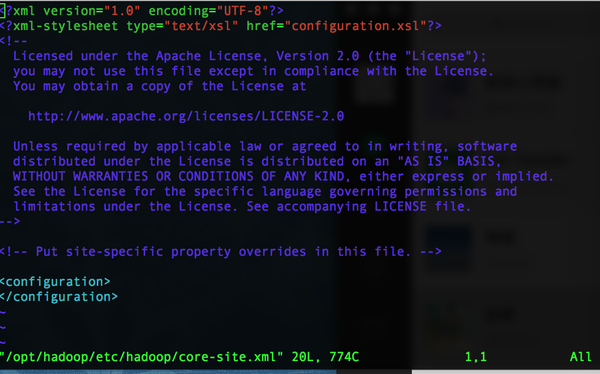

\5. 接下来需要利用vim来操作core-site 和 hdfs-site

1 | vim /opt/hadoop/etc/hadoop/core-site.xml |

进入vim环境

按下i(insert)修改

光标移动至configuration之间,复制如下的信息

1 | <property> |

然后按下esc,停止修改,然后打”:wq”(实际无“”)退出vim修改

同理操作hdfs-site

1 | vim /opt/hadoop/etc/hadoop/hdfs-site.xml |

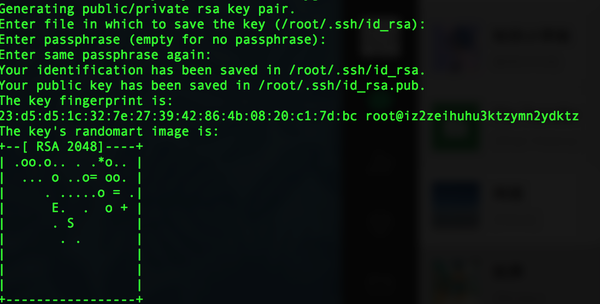

配置master和slave连接,运行如下指令,并且一直回车,直至出现如下图

1 | ssh-keygen -t rsa |

运行如下代码

1 | cd .ssh |

启动Hadoop

1 | hadoop namenode -format |

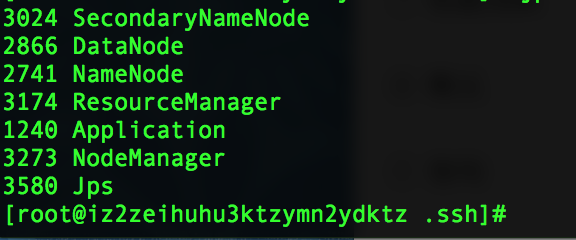

查看是否配置成功

1 | jps |

成功图

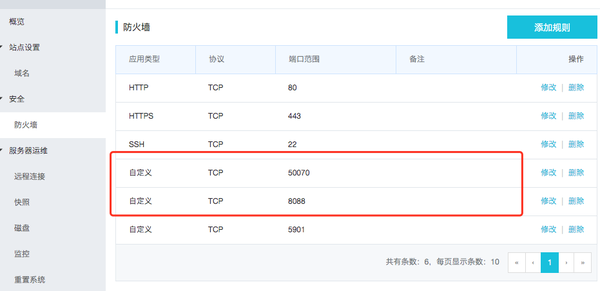

\7. 注意注意:接下来需要开启你在阿里云的防火墙端口,才可以在浏览器上访问,否则你怎么弄都是访问不到 (这里我卡了快一个礼拜,最后非常感谢阿里云的小哥哥帮我解决了这个问题)

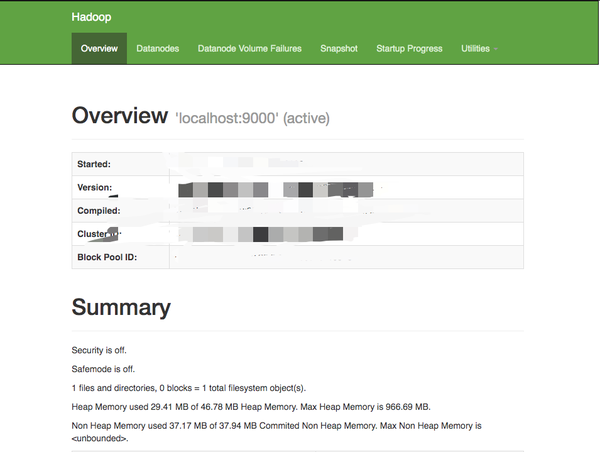

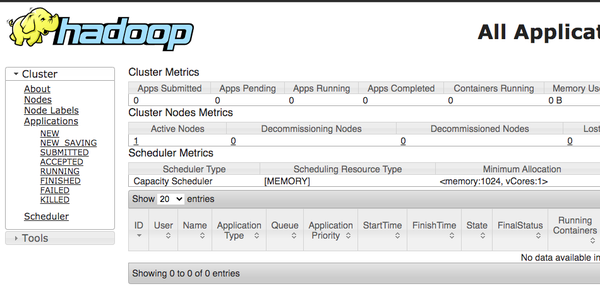

最后你就可以在浏览器输入XX.XX.XX.XX**:50070 或者**XX.XX.XX.XX:8088来在浏览器上访问你的Hadoop

效果图如下

以及

结语

因为我是一名大四生物信息的学生,对于计算机的至少掌握不是全,一些tcp-ip协议之类的指令没有掌握,所以很多都是一知半解,只是照着教程一步步装,若有错误,请大家指导。

- Post title:从阿里云轻量服务器安装Hadoop及环境配置

- Post author:Yuxuan Wu

- Create time:2021-01-25 20:35:27

- Post link:yuxuanwu17.github.io2021/01/25/从阿里云轻量服务器安装Hadoop及环境配置/

- Copyright Notice:All articles in this blog are licensed under BY-NC-SA unless stating additionally.